Qu’est-ce qu’un crawler ?

Un crawler est un programme qui accumule des données et des informations sur Internet en visitant des sites Web et en lisant les pages. Il est utilisé par les moteurs de recherche et est également connu sous le nom de spider. Ce programme stocke toutes les données et les liens externes et internes dans une banque de données. Il stocke des informations sur le contenu de la page Web, les balises méta, le titre de la page Web et bien plus encore. Il aide à l’indexation des sites Web, en parcourant une page à la fois jusqu’à ce que toutes les pages aient été indexées.

Glossaire du marketing d'affiliation

Découvrez le Glossaire du Marketing d'Affiliation de Post Affiliate Pro : une ressource complète pour comprendre les termes clés de l'industrie. De PPC à SEO, explorez les définitions de concepts essentiels comme les redirections, les logiciels de gestion d'affiliation, et plus encore. Parfait pour les débutants et les professionnels cherchant à enrichir leurs connaissances.

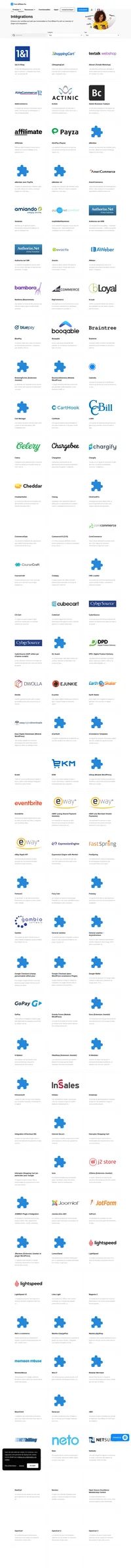

Découvrez les puissantes fonctionnalités de Post Affiliate Pro pour booster votre marketing d'affiliation. Offrez des réductions avec des coupons, bannières HTML et Smartlinks, et personnalisez votre interface multilingue. Améliorez votre stratégie avec des outils de suivi avancés et des rapports détaillés. Visitez notre page pour en savoir plus!