Les crawlers et leur rôle dans le classement des moteurs de recherche

Les crawlers accumulent des données et des informations sur Internet en visitant des sites web et en lisant leurs pages. Découvrez-en plus à leur sujet.

Découvrez comment fonctionnent les spiders SEO (robots d’indexation), leur rôle dans le marketing digital et d’affiliation, et pourquoi il est crucial d’optimiser votre site pour eux.

Les spiders en marketing digital, également appelés robots d’indexation, sont des programmes automatisés utilisés par les moteurs de recherche pour explorer les pages web sur Internet. Ces spiders analysent minutieusement le contenu, les balises méta et la structure d’un site web, suivant les liens pour naviguer d’une page à l’autre. Les données recueillies lors de ce processus sont essentielles pour déterminer la pertinence et l’autorité d’un site, ce qui influence son classement dans les résultats des moteurs de recherche.

Le marketing d’affiliation repose sur des partenariats entre marques et affiliés pour promouvoir des produits et services. Les spiders jouent un rôle clé dans cet écosystème en veillant à ce que les sites affiliés soient bien indexés et classés, ce qui influence leur visibilité et leur trafic.

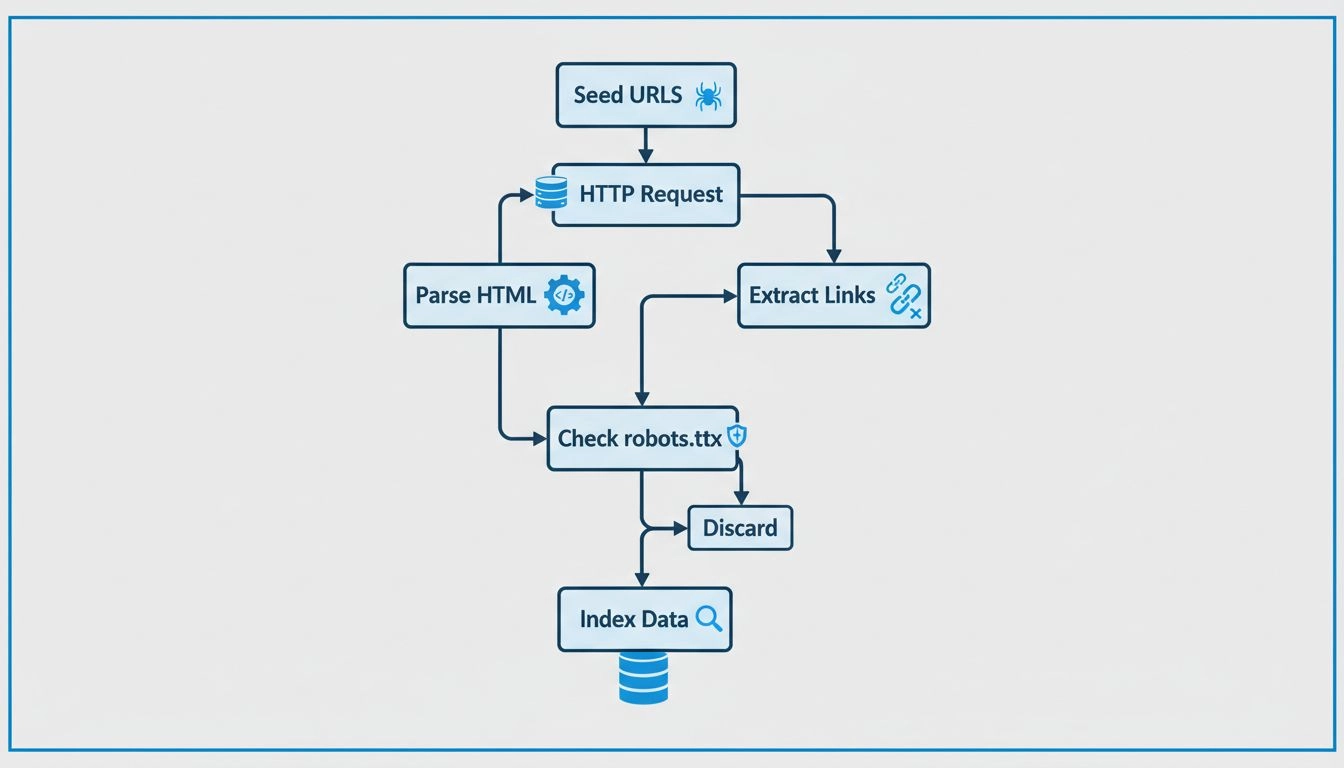

Les spiders commencent à partir d’un ensemble d’URL connues et visitent systématiquement des pages web. Ils analysent la structure HTML, extraient les informations pertinentes et suivent les liens vers de nouvelles pages. Ce processus comprend plusieurs étapes clés :

Malgré leur efficacité, les spiders font face à plusieurs défis :

robots.txt, ce qui influe sur l’indexation.Bien que “spider” et “robot d’indexation” soient souvent utilisés de manière interchangeable, une nuance existe. Les spiders se concentrent principalement sur l’indexation du contenu pour les moteurs de recherche, tandis que les robots d’indexation peuvent aussi être utilisés à d’autres fins, telles que l’extraction ou l’analyse de données.

Le SEO est un élément clé du marketing d’affiliation , et les spiders en sont au cœur des stratégies. En comprenant leur fonctionnement, les marketeurs peuvent :

Les logiciels de marketing d’affiliation intègrent souvent des fonctionnalités de robots d’indexation pour :

Trafic de bots : Un trafic non humain qui peut fausser les analyses et impacter les indicateurs de performance.

Cloaking : Présenter un contenu différent aux spiders et aux utilisateurs, ce qui peut entraîner des pénalités de la part des moteurs de recherche.

Fermes de liens : Un excès de liens non pertinents qui peut désorienter les spiders et détériorer le classement SEO.

Cela dépend du virus spécifique et du système informatique concerné. Cependant, certains des virus les plus compliqués à supprimer sont les rootkits, les bootkits et les virus sans fichier. Ces types de malwares peuvent être difficiles à détecter et se cachent profondément dans le système d'exploitation, rendant leur suppression extrêmement délicate.

Le spider de Google est un robot utilisé par Google pour explorer les sites web et indexer leur contenu.

Découvrez comment comprendre les spiders web peut vous aider à optimiser votre site pour de meilleurs classements et des revenus d'affiliation accrus.

Les crawlers accumulent des données et des informations sur Internet en visitant des sites web et en lisant leurs pages. Découvrez-en plus à leur sujet.

Les spiders informatiques sont des bots spéciaux conçus pour spammer votre adresse e-mail ou votre page web. Pour prévenir les attaques sur vos sites, utilisez ...

Découvrez comment fonctionnent les crawlers web, des URLs sources à l'indexation. Comprenez le processus technique, les types de crawlers, les règles robots.txt...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.